ابزارهای مبتنیبر هوش مصنوعی در ماههای اخیر بهشدت محبوب و خبرساز شدهاند. برخی از این ابزارها همچون انسان با شما حرف میزنند و برخی دیگر توانایی جنگاوری دارند و چند سرویس نیز از روی متن عکس میسازند. در این خبر به خواندن ذهن با هوش مصنوعی می پردازیم.

خواندن ذهن با هوش مصنوعی

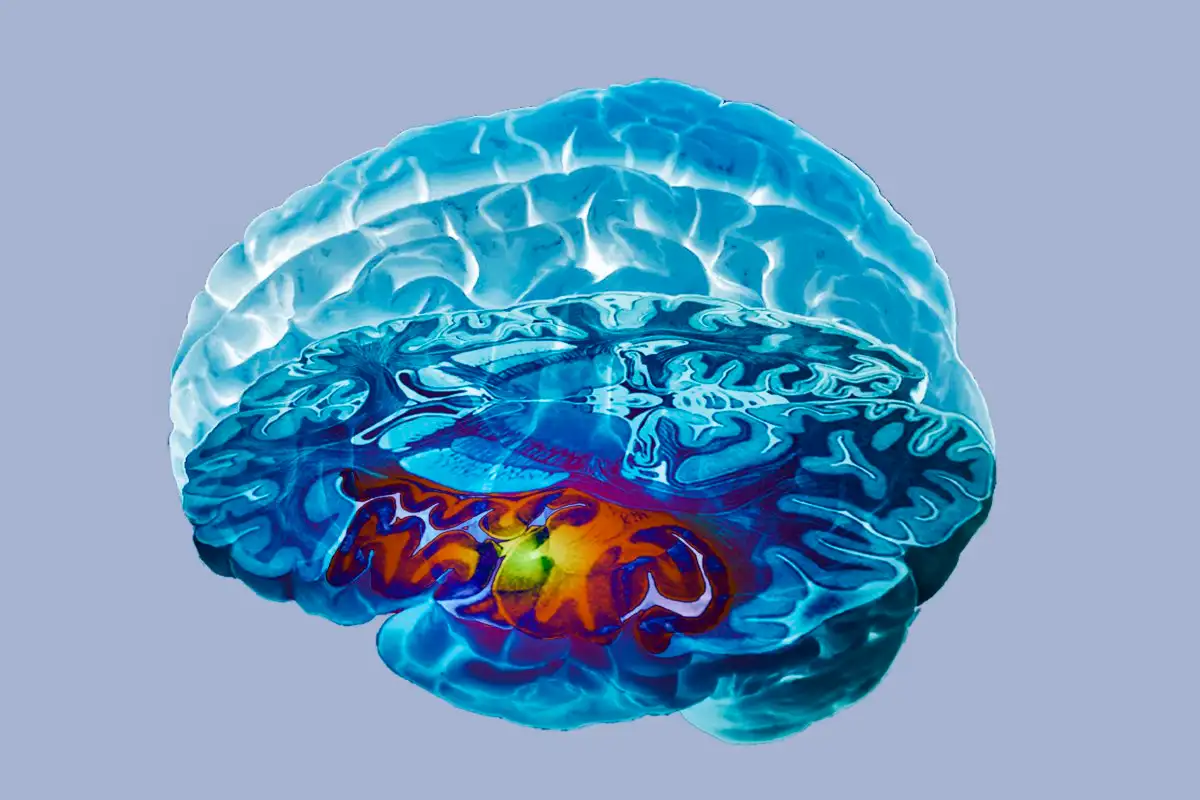

دانشمندان توانستهاند ازطریق ابزار تبدیل متن به عکس، سیگنالهای مغز را مستقیماً به عکس تبدیل کنند. این سیستم نیازمند تجهیزات بزرگ و پرهزینه است و فاصلهی زیادی با دورانی داریم که بتوان هرروز ذهنخوانی کرد.

چند گروه تحقیقاتی پیشتر توانستهاند با استفاده از مدلهای هوش مصنوعی، سیگنالهای مغز را به حالت تصویری دربیاورند. البته این مدلها به انرژی بسیار زیادی نیاز دارند و برای کار با آنها باید میلیونها تا میلیاردها پارامتر را بهطوردقیق تنظیم کرد.

شینجی نیشیموتو و یو تاکاگی، از اعضای دانشگاه اوساکای ژاپن، راهکار بسیار سادهتری ازطریق ابزار Stable Diffusion توسعه دادهاند. سال گذشته شرکت Stability AI این ابزار را منتشر کرد؛ ابزاری که میتواند از روی متن عکس بسازد و راهکار جدید دانشمندان ژاپنی بهجای میلیونها پارامتر به چندهزار پارامتر نیاز دارد.

Stable Diffusion در حالت عادی پس از دریافت متن، شروع به ساخت تصادفی نویز بصری میکند. Stable Diffusion سپس اصلاحاتی در آن اِعمال میکند و تصاویری میسازد که مشابه تصاویر موجود در دیتاستش با توضیح مشابه هستند. ابزارهای هوش مصنوعی برپایهی حجم عظیمی از دادهها که دیتاست نام دارد، تعلیم داده میشوند.

نیشیموتو و تاکاگی دو مدل هوش مصنوعی جدید به Stable Diffusion اضافه کردند تا این سرویس با سیگنالهای مغز سازگار شود. این دو دانشمند از دادههای چهار نفر که در مطالعهای دیگر شرکت کرده بودند، بهره گرفتند. در آن مطالعه، از سیستم fMRI برای اسکن مغز شرکتکنندگان استفاده شد؛ در شرایطی که آنها مشغول تماشای ۱۰٬۰۰۰ عکس مختلف از مناظر و اشیاء و مردم بودند.

نیشیموتو و تاکاگی با بهرهگیری از تقریباً ۹۰ درصد دادههای تصویربرداری مغز، مدل هوش مصنوعی جدیدی تعلیم دادند که میتواند بین دادههای fMRI بخشی از مغز به نام قشر بینایی اولیه و تصاویری ارتباط برقرار کند که شرکتکنندگان در حال تماشایش بودند. قشر بینایی اولیه ناحیهای در مغز انسان است که سیگنالهای بصری را پردازش میکند.

دانشمندان ژاپنی از همان دیتاست بهمنظور تعلیم مدلی دیگر استفاده کردند. این مدل هوش مصنوعی بین توضیحات متنی تصاویر و دادههای fMRI بخشی از مغز به نام قشر بینایی ثانویه ارتباط برقرار میکند. این ناحیه از مغز، توانایی پردازش معنای تصاویر را دارد.

دانشمندان ژاپنی هریک از دو مدل هوش مصنوعی یادشده را برای تکتک شرکتکنندگان در مطالعه شخصیسازی کردند. این مدلها پس از پایان فرایند تعلیم توانستند دادههای تصویربرداری از مغز را به فرمتی تبدیل کنند که بتوان آنها را مستقیماً وارد Stable Diffusion کرد.

Stable Diffusion توانست با دقت نزدیک به ۸۰ درصد حدوداً ۱٬۰۰۰ تصویر را بازسازی کند که شرکتکنندگان مشاهده کرده بودند. توجه کنید که Stable Diffusion در این حالت براساس تصاویر اصلی تعلیم داده نشده بود.

میزان دقت راهکار جدید نیشیموتو و تاکاگی مشابه مطالعهی دیگری است که در روندی بسیار خستهکننده، همان دادهها را تحلیل کرد. درواقع، دانشمندان ژاپنی موفق شدهاند سیستمی بسازند که دستاوردهای قبلی را سادهتر امکانپذیر میکند. تاکاگی میگوید: «نمیتوانستم به چشمانم باور کنم. به توالت رفتم تا در آینه خودم را ببینم و سپس به پشت میزم برگشتم تا باردیگر مانیتور را نگاه کنم.»

مطالعهی دانشمندان ژاپنی صرفاً روی چهار نفر انجام شد. نیشیموتو میگوید ابزارهای ذهنخوان هوش مصنوعی روی برخی از افراد بهتر از بقیه کار میکنند. ازآنجاکه مدلهای هوش مصنوعی باید برای مغز هر فرد شخصیسازی شوند، این راهکار نیازمند جلسات طولانی اسکن مغز و دستگاههای بزرگ fMRI است. یکی از دانشمندان میگوید راهکار یادشده اصلاً برای استفادهی روزمره مفید نیست.